初识AI绘画,是谷歌的在线AI程序深度梦境Deep Dream,一个上传照片后选择一个滤镜对照片进行处理从而形成梦幻效果的在线程序。名字叫深度梦境,但是要作出一张真正梦境般的图片并不容易,处理后的照片能够明显看出原来的图案是什么,是应用了什么样风格的滤镜进行的处理,是一种显而易见的融合及结合。比如下面这张照片,无印良品里的杯碟架子变成高楼林立的都市:

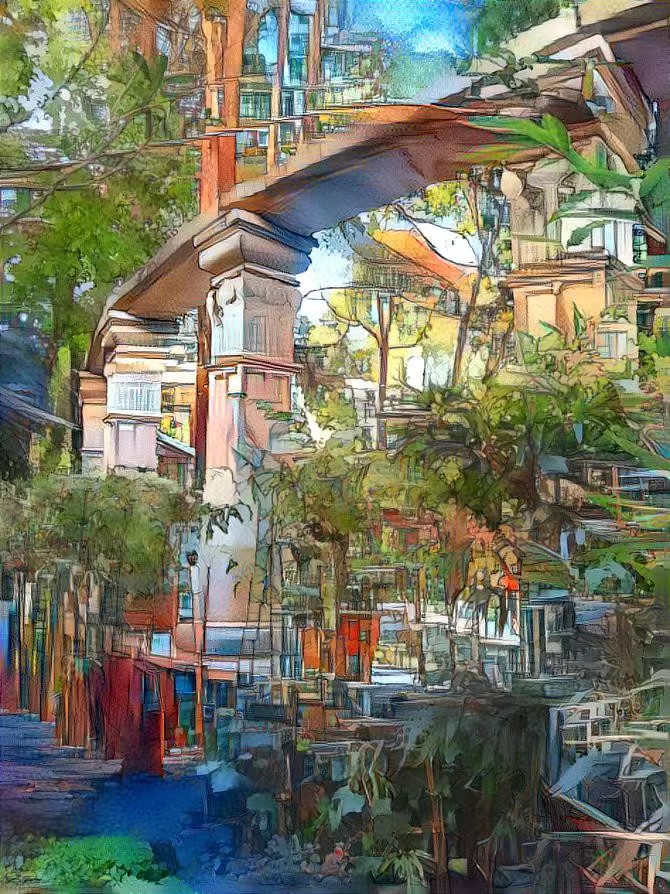

或者是这样,丛林里的城市只是房屋后院的梦呓:

五彩缤纷的效果是容易形成的效果:

或是电子游戏争霸战的赛博朋克风格:

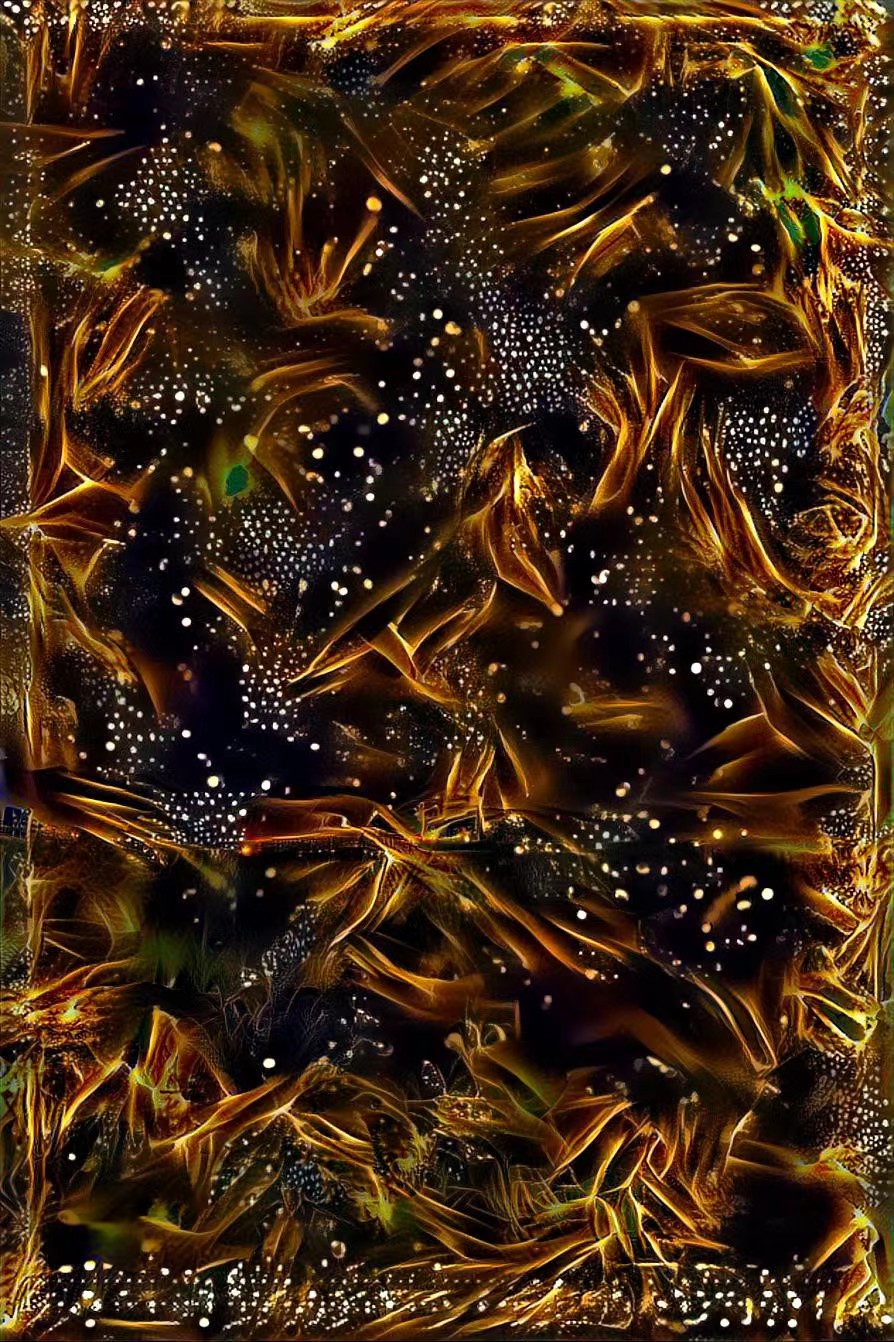

深度梦境真正给我惊喜的,是这样一张照片,这是一张银河的星野照片,能想象经过滤镜后变成另外这样一种星空的样子吗?

在祛除了不切实际的梦幻设想后,深度梦境其实更能给我们一些例如油画、水粉画这样的处理效果:

然后,我遇到了谷歌的深度学习算法Disco Diffusion,用Tensorflow训练模型,在线运行可使用谷歌的在线GPU提高运行速度,也可以下载到本地机器运行,但由于我的电脑的硬件性能远远无法达到跑这个模型的需求,所以始终只能在线上进行运行。DD的特点,是用一句包含若干关键词的话来告诉程序想要一幅什么样的画。不做修改时,默认的关键词是这样的:

"A beautiful painting of a singular lighthouse, shining its light across a tumultuous sea of blood by greg rutkowski and thomas

kinkade, Trending on artstation.", "yellow color scheme”

这样画出来的是灯塔:

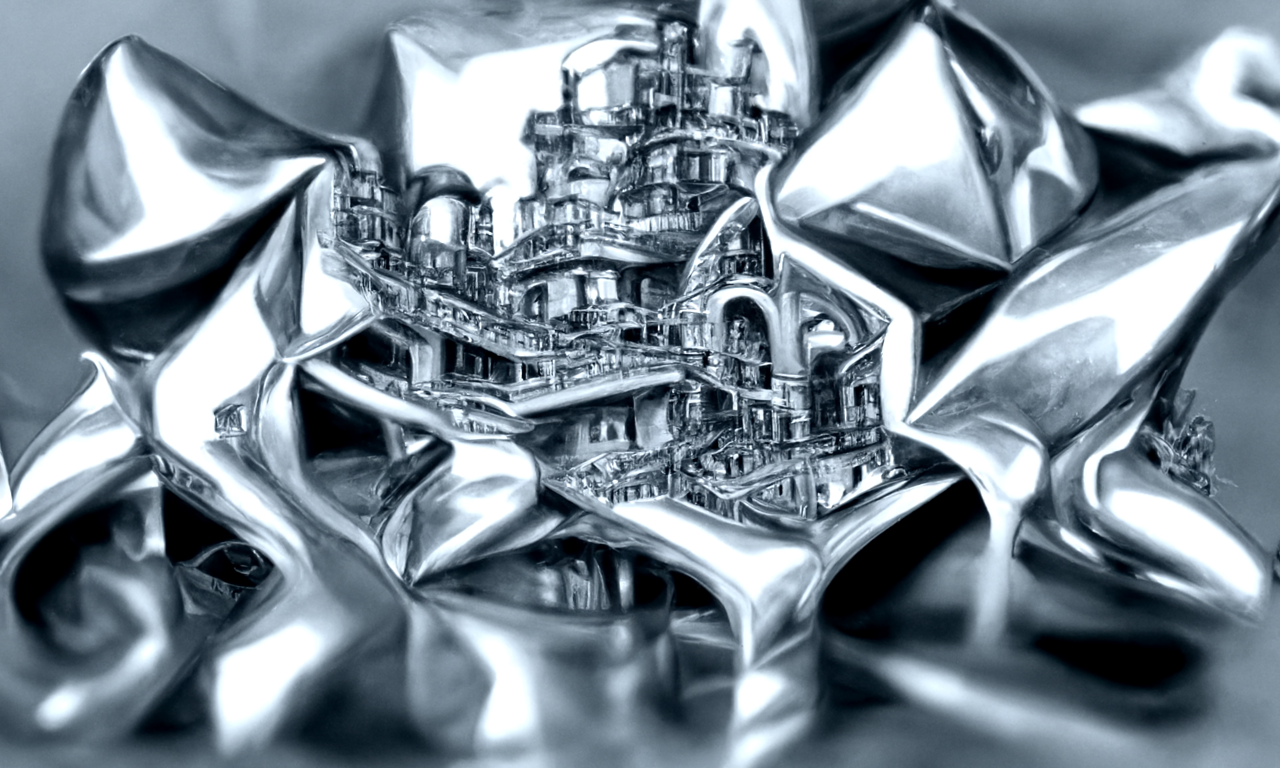

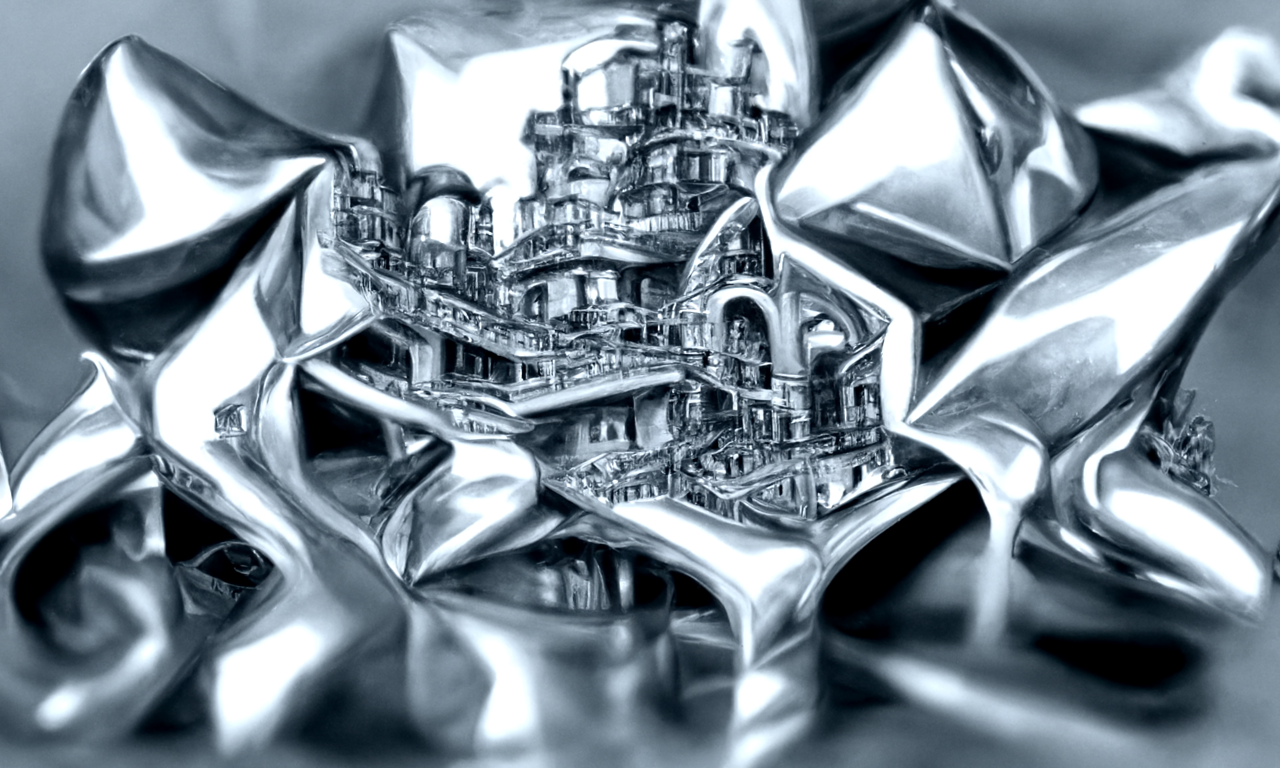

一直想要画一张赛博朋克风格的画,所以我用了这句关键词:"A sense of awe of a steampunk Industrial City,filled with holograms by M.C. Escher, Trending on surreal.","silver color scheme"

结果挺出人意料:

另一个想要的场景是帆船在波涛汹涌的大海上,所以我用了这句关键词: "A beautiful painting of a ultrawide shot of a sailboat ,sailing in rough sea by greg rutkowski and thomas kinkade, trending on artstation."结果不满意。

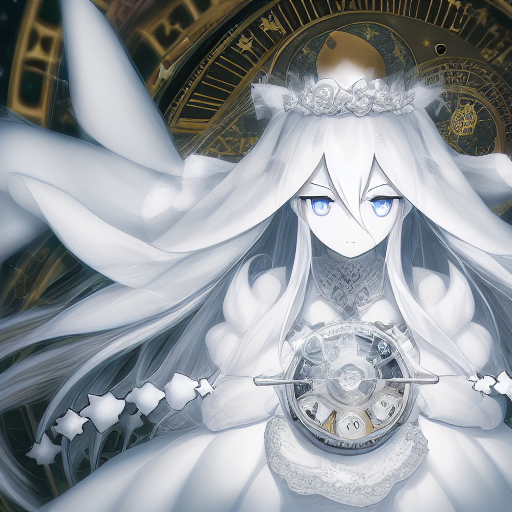

这句关键词:"A sense of awe of the end of time ,a desire for knowledge by Hiroshi Yoshida and Marc Simonetti, trending on futuristic."第一张就非常好,但是后面的图画就每况愈下,所以只保留了这一张:

由于末世流的风格效果很好,于是我又调整了关键词:"A sense of awe of the end of civilization by Ivan Aivazovsky and Peter Mohrbacher, trending on futuristic."至于效果......只能说不好,嫁接的痕迹太严重。

AI绘画的程序还有很多,AI绘画到底能不能代替人类的绘画呢?其他的程序我不知道,DD我看难。用一句话来告诉程序想要画什么,这其中的不确定性太多,按理说不确定性是灵感的来源,可偏偏这程序的程式化还是太严重,这就造成了画作的移花接木和可以理解的混合。对于抽象艺术而言,能够理解便落了下乘,更何况能把自己的幻想明白说出来的话,那幻想还是幻想吗?